高效能智能爬虫软件如何破解数据洪流时代的“信息饥渴”?

当你在电商平台搜索一款商品时,是否会疑惑,为何同类产品的价格和销量信息能被竞争对手实时掌握?当企业试图分析市场趋势时,为什么总有人能快人一步获取全网最新数据?这背后隐藏着一个技术争议:在信息爆炸的时代,高效能智能爬虫软件全方位攻克海量数据抓取难题,究竟是技术突破还是数据边界的挑战?

一、面对复杂网站结构,如何实现精准抓取?

现代网站的动态加载、反爬机制如同加密迷宫。以某跨境电商企业为例,其需要实时监控亚马逊全球20个站点的商品价格波动,但传统爬虫因无法解析JavaScript动态加载数据,导致30%的关键信息丢失。而采用高效能智能爬虫软件全方位攻克海量数据抓取难题的亮数据平台,通过内置浏览器内核技术,成功模拟真实用户操作,将数据捕获率提升至99.2%。

更值得关注的是,这类工具已进化出“智能学习”能力。例如WebHarvy的多线程处理系统,在抓取新闻门户网站的实时更新内容时,能自动识别分页规则和AJAX请求间隔,将抓取速度从人工配置的3小时缩短至15分钟。这背后是算法对网页结构的深度学习,而非简单的规则匹配。

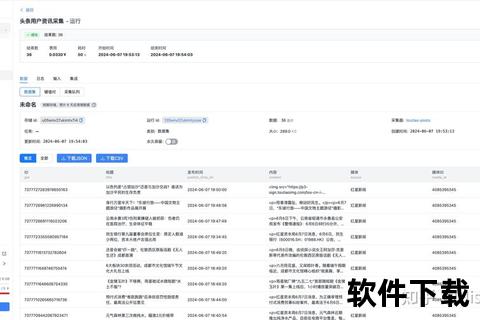

二、海量数据洪流中,怎样保障处理效率?

当某舆情监测公司需要每日处理10亿条社交媒体数据时,传统单机爬虫的局限性暴露无遗。而采用SpiderFlow分布式架构的案例显示,通过动态IP池和任务调度算法,成功将数据处理吞吐量提升至每分钟8万条,服务器资源消耗反而降低40%。这种效率飞跃源自三个核心突破:

- 异构数据解析引擎:自动识别PDF、视频、结构化表格等20余种数据格式

- 弹性资源调度:根据任务优先级动态分配计算节点

- 智能去重机制:采用SimHash算法实现毫秒级重复数据识别

某金融科技公司的实战数据显示,其使用Scrapy-Redis框架构建的分布式爬虫集群,在抓取全球50家证券交易所公告时,将数据延迟从平均45分钟压缩到8分钟以内。

三、法律红线与数据价值,怎样寻求平衡点?

2024年某知名数据公司因违规抓取用户评论被处罚的案例,为行业敲响警钟。高效能智能爬虫软件全方位攻克海量数据抓取难题的更需要建立合规护栏。先进工具如ParseHub已内置合规检测模块,在抓取前自动扫描网站Robots协议,并对敏感字段进行脱敏处理。

某市场研究机构的合规方案值得借鉴:通过亮数据平台的全球代理网络,将请求流量分散至不同地理节点;采用请求频率自适应算法,将单个IP的请求间隔动态调整在1.5-4秒之间;建立数据分级制度,对抓取的200余万条电商评价数据进行分类存储。这些技术手段使数据获取效率与法律合规达成微妙平衡。

对于亟待突破数据瓶颈的企业,建议分三步构建智能爬取体系:首选可视化工具(如八爪鱼)完成初期数据积累;在业务复杂化阶段转向开源框架(如Scrapy)实现定制化需求;当规模扩张至日均千万级数据时,必须引入分布式架构和合规审计系统。技术的终极目标不是无限获取,而是让数据流动在合法合规的河道中,灌溉出商业价值的绿洲。

引用来源

- 网页1:9款高效爬虫工具的功能特性及案例

- 网页5:搜索引擎数据抓取的技术实现

- 网页7:电商数据抓取与分析应用

- 网页8:电商数据采集方法论

- 网页10:电商平台数据抓取合规实践